Capítulos

Intervalos característicos

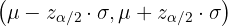

El intervalo característico con nivel de confianza  para una distribución normal

para una distribución normal  está dado por

está dado por

Aquí, el nivel de confianza  es la probabilidad de que un número que siga la distribución normal caiga dentro del intervalo.

es la probabilidad de que un número que siga la distribución normal caiga dentro del intervalo.

El nivel de significación se denota como  . La media de la distribución es

. La media de la distribución es  y la desviación estándar es

y la desviación estándar es  . El valor crítico del intervalo se denota como

. El valor crítico del intervalo se denota como  .

.

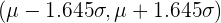

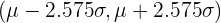

La siguiente tabla resume algunos de los intervalos característicos más comunes:

|  |  | Intervalos característicos |

|---|---|---|---|

| 0.90 | 0.05 | 1.645 |  |

| 0.95 | 0.025 | 1.96 |  |

| 0.99 | 0.005 | 2.575 |  |

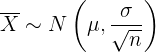

Teorema central del límite

Consideremos una población  con media

con media  , desviación estándar

, desviación estándar  y tamaño de muestra

y tamaño de muestra  . Entonces la media

. Entonces la media  sigue una distribución aproximadamente normal, es decir,

sigue una distribución aproximadamente normal, es decir,

El tamaño de muestra debe ser  . Si la población original

. Si la población original  sigue una distribución normal, entonces

sigue una distribución normal, entonces  puede tener cualquier valor.

puede tener cualquier valor.

Estimación de medias y proporciones

Estimación de la media de una población

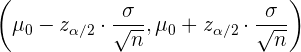

Realizamos la estimación por medio de intervalos de confianza. En el caso de la media, el intervalo de confianza con significación  es

es

donde  es la media de la muestra,

es la media de la muestra,  es la desviación estándar de la población,

es la desviación estándar de la población,  es el tamaño de la muestra y

es el tamaño de la muestra y  es el valor crítico de la distribución normal estándar.

es el valor crítico de la distribución normal estándar.

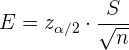

En este caso, el error de estimación es

Además, si ya conocemos la significación  , la desviación estándar

, la desviación estándar  y el error deseado

y el error deseado  , entonces el tamaño de muestra se calcula utilizando

, entonces el tamaño de muestra se calcula utilizando

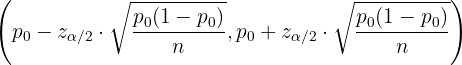

Estimación de una proporción

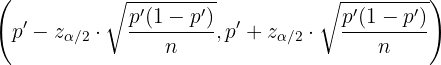

Para el caso de la proporción, el intervalo de confianza con significación  es

es

donde  es la proporción de la muestra,

es la proporción de la muestra,  es el valor crítico de la distribución normal y

es el valor crítico de la distribución normal y  es el tamaño de muestra.

es el tamaño de muestra.

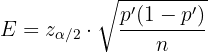

Aquí, el error máximo de estimación es

Con las proporciones es común escribir  , donde

, donde  es la probabilidad de éxito y

es la probabilidad de éxito y  es la probabilidad de fracaso (de que un individuo de la población tenga una propiedad dada).

es la probabilidad de fracaso (de que un individuo de la población tenga una propiedad dada).

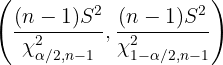

Estimación de la desviación estándar

En el caso de la desviación estándar  , se calcula el intervalo de confianza de la varianza

, se calcula el intervalo de confianza de la varianza  , que está dado por

, que está dado por

donde  es el tamaño de muestra,

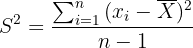

es el tamaño de muestra,  es la varianza de la muestra y se calcula utilizando

es la varianza de la muestra y se calcula utilizando

donde  es la media de la muestra. Por último,

es la media de la muestra. Por último,  y

y  son los valores críticos de una distribución

son los valores críticos de una distribución  ; estos valores se calculan un programa de computadora o se obtiene de una tabla chi.

; estos valores se calculan un programa de computadora o se obtiene de una tabla chi.

Pruebas de hipótesis

El procedimiento para hacer una prueba de hipótesis para el parámetro  de una población es el siguiente:

de una población es el siguiente:

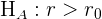

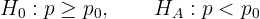

1 Se enuncia la hipótesis nula  y la hipótesis alternativa

y la hipótesis alternativa  . Donde la hipótesis nula hace algún supuesto sobre el valor de

. Donde la hipótesis nula hace algún supuesto sobre el valor de  y

y  es el supuesto contrario. La siguiente tabla resume las posibles pruebas de hipótesis:

es el supuesto contrario. La siguiente tabla resume las posibles pruebas de hipótesis:

| Bilateral |  |  |

| Unilateral |  |  H_A: r < r_0[/latex] H_A: r < r_0[/latex] |

|  |

2 Determinar el nivel de significación  y a partir de ahí obtener los valores críticos

y a partir de ahí obtener los valores críticos  (para el caso bilateral) o

(para el caso bilateral) o  (para el caso unilateral).

(para el caso unilateral).

3 Determinar la zona de aceptación del parámetro muestral.

4 Calcular el valor del parámetro muestral  .

.

5 Obtener la conclusión. Si el valor del parámetro muestral está dentro de la zona de aceptación, entonces aceptamos la hipótesis nula con un nivel de significación  . En caso contrario, rechazamos la hipótesis nula.

. En caso contrario, rechazamos la hipótesis nula.

Contraste bilateral

Cuando tenemos un contraste bilateral, si estamos probando una hipótesis para la media  de la población, es decir,

de la población, es decir,

entonces la región de aceptación es

Por otro lado, si la prueba de hipótesis es para la proporción  ,

,

entonces la región de aceptación es

donde  es la desviación estándar de la población,

es la desviación estándar de la población,  es el tamaño de la muestra y

es el tamaño de la muestra y  es el valor crítico de la distribución.

es el valor crítico de la distribución.

Contraste unilateral mayor o igual que

Cuando tenemos un contraste unilateral del tipo "mayor o igual que", si estamos probando una hipótesis para la media  de la población, es decir,

de la población, es decir,

entonces la región de aceptación es

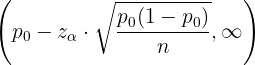

Por otro lado, si la prueba de hipótesis es para la proporción  ,

,

entonces la región de aceptación es

donde  es la desviación estándar de la población,

es la desviación estándar de la población,  es el tamaño de la muestra y

es el tamaño de la muestra y  es el valor crítico de la distribución.

es el valor crítico de la distribución.

Contraste unilateral menos o igual que

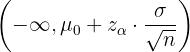

Cuando tenemos un contraste unilateral del tipo "menor o igual que", si estamos probando una hipótesis para la media  de la población, es decir,

de la población, es decir,

entonces la región de aceptación es

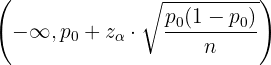

Por otro lado, si la prueba de hipótesis es para la proporción  ,

,

entonces la región de aceptación es

donde, de nuevo,  es la desviación estándar de la población,

es la desviación estándar de la población,  es el tamaño de la muestra y

es el tamaño de la muestra y  es el valor crítico de la distribución.

es el valor crítico de la distribución.

La siguiente tabla resume los valores críticos  para distintos valores de

para distintos valores de  que se utilizan para las pruebas unilaterales:

que se utilizan para las pruebas unilaterales:

|  |  |

|---|---|---|

| 0.90 | 0.10 | 1.28 |

| 0.95 | 0.05 | 1.645 |

| 0.99 | 0.01 | 2.33 |

Errores

Recordemos que existen dos tipos de errores: el error tipo I que ocurre cuando rechazamos la hipótesis nula siendo verdadera, y el error tipo II que ocurre cuando aceptamos la hipótesis nula siendo falsa.

La siguiente tabla resume los tipos de errores:

| Verdadera | Falsa |

|---|---|---|

| Aceptar | Decisión correcta Probabilidad de  | Decisión incorrecta: Error tipo II |

| Rechazar | Decisión incorrecta Error tipo I Probabilidad de  | Decisión correcta |

Resumir con IA:

Apuntes es una plataforma dirigida al estudio y la práctica de las matemáticas a través de la teoría y ejercicios interactivos que ponemos a vuestra disposición. Esta información está disponible para todo aquel/aquella que quiera profundizar en el aprendizaje de esta ciencia. Será un placer ayudaros en caso de que tengáis dudas frente algún problema, sin embargo, no realizamos un ejercicio que nos presentéis de 0 sin que hayáis si quiera intentado resolverlo. Ánimo, todo esfuerzo tiene su recompensa.

El servicio de emergencia para ciertas áreas rurales de Ohio con frecuencia es un problema, especialmente durante los meses de invierno. El jefe del Departamento de Bomberos de Danville, Township está preocupado por el tiempo de respuesta a las llamadas de emergencia. Ordena una investigación para determinar si la distancia del lugar de la llamada, medida en millas, puede explicar el tiempo de respuesta, medido en minutos.Con base en 37 emergencias, se recolectaron los siguientes datos: ∑X = 234 EY = 831 ∑XY = 5,890

2X*=1.796 2r² =20,037

a. ¿Cuál es el tiempo de respuesta a una llamada que proviene de ocho millas de la estación de bomberos?. ¿Qué tan dependiente es dicha estimación, con base en el grado de dispersión de los puntos de datos alrededor de la recta de regresión?

De una población de 2,500 estudiantes de la universidad Unibe 60% Ingeniería industrial, con un nivel de confianza de 95% y un margen de error de 5%, determine la muestra?

Nota: cuando no conocemos el valor de p y q se les asigna 50% a cada uno y las cantidades que aparecen en porcentaje debe dividirse en 100.

La alcaldía de la ciudad está preocupada por el retiro masivo de las industrias hacía la capital del país, por lo usted como un importante analista en términos económicos lo debe asesorar, se seleccionó una muestra de 500 empresas de las cuales la 300 aún permanecen en la ciudad, la proporción de empresas que han salido de la ciudad se encuentra entre:

Pregunta 5Seleccione una:

a.

40 y 60%

b.

46 y 56%

c.

36 y 44 %

d.

30 y 40 %

En la siguiente tabla se presentan las cantidades promedio de jugo de frutas que empacan, en bolsas de litro, tres máquinas empacadas de una agroindustria.

-MAQUINAS

A

B

C

-PROMEDIO EMPACADO POR BOLSA

1.039 LTS

0.989 LTS

1.090 LTS

-DESVIACIÓN ESTANDAR

0.332 LTS

0.350 LTS

0.371 LTS

¿Cuál de las 3 máquinas tiene la cantidad promedio de empacado por bolsa más confiable? ¿Por qué?

ejercicio. En una ciudad de 100.000 habitantes, se quiere estimar la proporción de personas que utilizan bicicleta como medio de transporte. ¿Cuántas personas deben incluirse en la muestra para obtener un margen de error del 5% con un nivel de confianza del 95%?

10.- Las estaturas de cierta población se distribuyen N(168,8). Calcula la probabilidad de que en una muestra de 36 personas la altura media no difiera de la de la población en más de 1 cm.

28 28 28 28 24 24 20 20 20 20 20 25 25 25 27 27 27 26 22 22 22

En una escuela de 150 estudiantes se requiere realizar una investigación sobre las preferencias de las áreas de los estudiantes y se debe calcular su muestra para conocer cuántos estudiantes se le debe aplicar la encuesta, determinando que el grado de confianza es del 95%, la probabilidad de éxito de 98% y el error de calculo del 6%.

Caso de estudio: En el Perú, el Ministerio de Salud (MINSA) está interesado en conocer la prevalencia de la depresión en los adolescentes de 12 a 17 años de edad en la ciudad de Lima. Para ello, el MINSA decide realizar una encuesta a una muestra de adolescentes de esta población.

Objetivo:

El objetivo del caso de estudio es que los estudiantes apliquen la fórmula para estimar una proporción poblacional para estimar la prevalencia de la depresión en los adolescentes de 12 a 17 años de edad en la ciudad de Lima. También, debe indicar el tipo de muestreo probabilístico que deberá emplear.

¿Cuál debe ser el tamaño de muestra para estimar la prevalencia de la depresión, con un nivel de confianza del 95%, margen de error de 4%, e indica el método de selección de la muestra